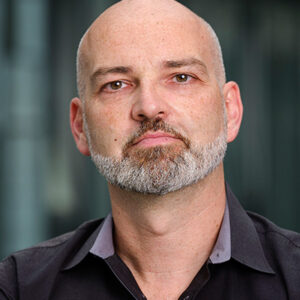

Was bedeutet die rasante Entwicklung im Bereich der generativen Künstlichen Intelligenz (KI) für die Wissenschaftskommunikation? Mike S. Schäfer hat sich in einem kürzlich erschienen Essay mit dieser Frage auseinandergesetzt und erklärt im Interview, was auf das Feld zukommt.

„Generative KI ist ein Gamechanger“

Herr Schäfer, der Chatbot ChatGPT sorgt seit Monaten für großes Aufsehen. Das Programm steht exemplarisch für die großen Fortschritte im Bereich der generativen KI. Was ist unter dem Begriff zu verstehen?

Generative KI ist ein Sammelbegriff für KI-Modelle, die auf Anfragen von Nutzer*innen menschenähnliche Antworten geben oder Ergebnisse produzieren. Diese Antworten werden auf Basis von Trainingsdaten erstellt. Während die ersten Versionen von ChatGPT und anderen großen Sprachmodellen wie Google Bard oder Anthrophic Claude primär Texte generieren, gibt es auch Systeme, die Bilder, Videos oder Audiomaterial erzeugen oder diese Modalitäten kombinieren.

Welche Rolle kann generative KI für die zukünftige Praxis der Wissenschaftskommunikation spielen?

Generative KI ist ein Gamechanger. Und das sage ich nicht leichthin. Wenn man Prognosen über die zukünftigen gesellschaftlichen Auswirkungen von Technologien abgibt, müssen immer mindestens zwei Faktoren berücksichtigt werden. Ein Faktor ist das technologische Potenzial, der andere ist die gesellschaftliche Verbreitung. Das rein technische Potenzial einer Technologie allein reicht für eine weite gesellschaftliche Verbreitung nicht aus, auch vielversprechende Technologien können an mangelnder gesellschaftlicher Anschlussfähigkeit scheitern.

„Social Construction of Technology“-Ansätze haben in schönen Fallstudien über Fahrrad-Modelle oder Kühlschränke gezeigt, dass nicht nur technische, sondern auch soziale Prozesse entscheidend sind. Diesbezüglich steht das finale Urteil bei generativer KI natürlich noch aus. Aber zu konstatieren ist schon mal, dass sie innerhalb von kürzester Zeit massive Nutzung erfahren. ChatGPT hatte 1 Million Nutzer*innen in einer Woche, und 100 Millionen innerhalb von 2 Monaten, das ist wohl eine der schnellsten Verbreitungen einer Technologie in der Geschichte der Menschheit.

Kann generative KI auch bei der Durchführung von Kommunikationsformaten eingesetzt werden?

Seit langem gelten partizipative und dialogische Formate ja für viele Kolleg*innen als so etwas wie der Königsweg der Wissenschaftskommunikation. Es ist jedoch oft nicht einfach, diese Formate zu skalieren und für größere Nutzer*innengruppen zugänglich zu machen. Stattdessen hat man es häufig mit kleinen, stark vor- oder selbst-selektierten Teilnehmenden zu tun. Generative KI ist hier grundsätzlich interessant. Sie könnte zukünftig in der Lage sein, so etwas wie eine skalierte partizipative Wissenschaftskommunikation zu liefern und größere Publikumsgruppen zu erreichen, als dies jetzt möglich ist. Also es den Nutzer*innen möglich machen, in einen Dialog zu treten, Rückfragen zu stellen, Dinge nochmal einfacher erklären zu lassen, in die Tiefe zu gehen oder auch Beispiele zu erhalten. Ich sage nicht, dass das ganz einfach und für jedes Thema gleich gut umgesetzt werden kann. Zudem wird KI mittelfristig natürlich nicht die Tiefe an Partizipation und Interaktion erreichen, die sonst bei dialogischen Formaten möglich ist. Aber dennoch: Für die Wissenschaftskommunikations-Community sollte das interessant sein.

Was sind potenzielle Risiken für die Wissenschaftskommunikation?

Der Großteil der Diskussion dreht sich um die Korrektheit der generierten Antworten. ChatGPT und Co. produzieren ja Antworten, die sich dem annähern, was an Mustern in den Trainingsdaten steckt. Man bekommt zwar eine „neue“ Antwort, diese ähnelt aber statistisch dem großen, bereits vorhandenen Korpus an Daten. Und wie wir gesehen haben, sind diese Antworten nicht immer korrekt – die KI „halluziniert“, wie das teils genannt wird.

Ein weiteres, damit verbundenes Problem sind die Trainingsdaten. Wir wissen nicht genau, was in diesen Daten eigentlich drinsteckt, aber ziemlich sicher gibt es da klare Biases: Sind beispielsweise bestimmte Themen oder Weltregionen überrepräsentiert? Wie viel Fehlinformationen stecken in den Trainingsdaten und inwieweit beeinflussen diese die Antworten? Diese Verzerrungen zu kennen und in der Anwendung von generativer KI angemessen berücksichtigen zu können, ist von großer Bedeutung und gleichzeitig nur schwer zu gewährleisten.

Zeichnen sich noch weitere Risiken bei der Anwendung ab?

Klar, eine ganze Reihe. In der Literatur wird von der Gefahr einer KI-generierten Infodemie gesprochen, in der KI für die Verbreitung von Fehlinformationen in großem Stil missbraucht wird. Inwieweit Moderations- und Regulierungsversuche dies in den Griff bekommen, bleibt abzuwarten. Als letzten Punkt haben wir die Nutzer*innenseite: Häufig gibt es bei der Verbreitung und Aneignung von Technologien eine neu entstehende, sich reproduzierende oder sogar verstärkende Ungleichheit.

Das bedeutet, es gibt Bevölkerungsteile, die eher in der Lage sind, digitale Technologien zu nutzen als andere. Eine erste Stufe einer solchen digitalen Kluft ist der schiere Zugang, den manche Menschen nicht oder nur eingeschränkt haben, weil die Technologien für sie zu teuer sind. Als digitale Kluft der zweiten Stufe werden Unterschiede in Kompetenzen und Fähigkeiten bezeichnet, um die Technologie kompetent für sich nutzbar zu machen. Die generative KI so zu nutzen, dass man gute, verlässliche Antworten erhält – das können einige Menschen besser als andere.

Wie sollte über Programme wie ChatGPT mit der Bevölkerung kommuniziert werden?

Erste Studien zeigen ja, dass bisher nur eine Minderheit der Bevölkerung diese Programme getestet hat. In der Wissenschaftskommunikations-Community sind es sicherlich mehr, aber meiner Wahrnehmung nach längst nicht alle. Deshalb wäre mein Aufruf an unsere Community: Probiert es aus, experimentiert, lernt Vor- und auch Nachteile kennen! Man muss sich dem annähern und eine Weile dranbleiben, um einen eigenen Eindruck zu gewinnen und darüber kommunizieren zu können.

Mit der Kommunikation über generative KI verhält es sich grundsätzlich wie mit anderen wissenschaftlichen Themen auch. Es gibt nicht den einen Weg oder das eine Format, das für alle Zwecke geeignet ist. Das Hauptziel sollte sicherlich sein, angemessen und interaktiv die Chancen, aber auch die Begrenzungen dieser Tools zu diskutieren. Bei allen Einschränkungen muss aber aus meiner Sicht auch betont werden, dass wir hier von einer Technologie sprechen, die nicht wieder verschwinden wird. Da hilft es nicht, den Kopf in den Sand zu stecken. In der Zukunft wird es eine Kernaufgabe von Wissenschaftskommunikation, Pädagogik, Didaktik und weiteren Bereichen sein, Menschen dazu zu befähigen, generative KI kompetent, reflektiert und kritisch einzusetzen.

Hat sich Ihre eigene tägliche Arbeit seit dem Launch von ChatGPT verändert?

Auf jeden Fall. Ich versuche, bei all den vielfältigen Entwicklungen einigermaßen auf dem Laufenden zu bleiben. Ich verfolge intensiv, wie Expert*innen wie Ethan Mollick diese Technologien einsetzen und beurteilen. In nutze sie selbst: ChatGPT habe ich zum Beispiel, als ich den Artikel geschrieben habe, dosiert eingesetzt, um ChatGPT selbst kommentieren zu lassen. So etwas wie: „Stell dich mal vor!“ oder „Wie schätzt du deinen Einfluss auf Wissenschaftskommunikation ein?“